En un mundo donde la inteligencia artificial se ha convertido en una herramienta fundamental para la productividad y la creatividad, muchos usuarios buscan soluciones que no solo sean efectivas, sino también accesibles y respetuosas con la privacidad. Aquí es donde entra en juego DeepSeek-R1, un modelo de inteligencia artificial diseñado para ejecutarse de manera local en tu propio equipo.

DeepSeek-R1 se presenta como una alternativa robusta a otras soluciones basadas en la nube, permitiéndote trabajar sin depender de servidores externos, sin costos adicionales y con un control total sobre tus datos. Si alguna vez has querido experimentar con IA sin preocuparte por restricciones, políticas de uso o filtrado de información, esta es una excelente opción para ti.

En esta guía completa, basada en los conocimientos compartidos por la comunidad de usuarios de DeepSeek-R1, te explicaremos paso a paso cómo instalar y configurar este modelo en tu equipo. Además, veremos cómo optimizar su rendimiento y solucionar posibles problemas para que puedas aprovechar al máximo sus capacidades.

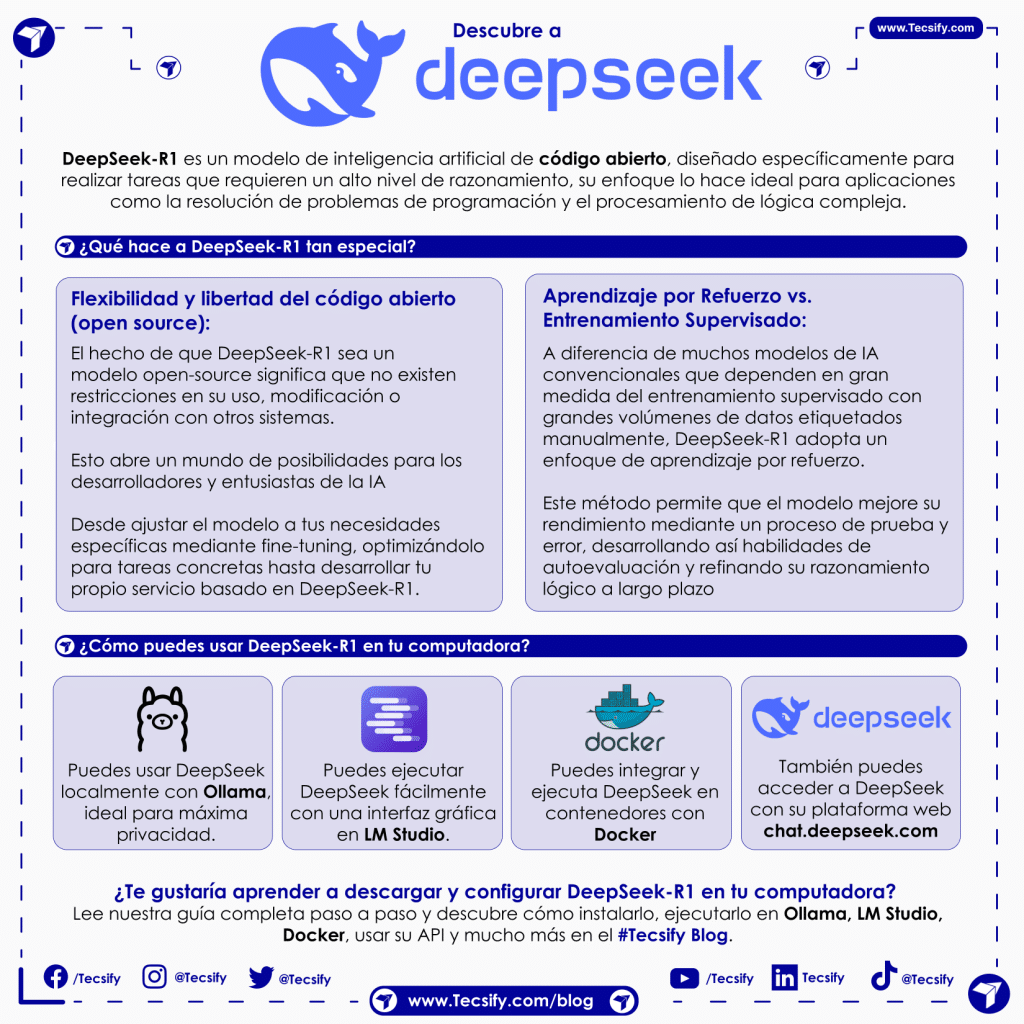

¿Qué es DeepSeek-R1?

DeepSeek-R1 es un modelo de inteligencia artificial de código abierto, completamente gratuito y diseñado específicamente para realizar tareas que requieren un alto nivel de razonamiento. Su enfoque lo hace ideal para aplicaciones como la resolución de problemas de programación, el análisis de matemáticas avanzadas y el procesamiento de lógica compleja.

Lo que diferencia a DeepSeek-R1 de muchas otras soluciones de IA es su capacidad para ejecutarse directamente en tu equipo, sin necesidad de conectarse a servidores externos. Esto significa que puedes utilizar sus capacidades sin comprometer tu privacidad ni depender de servicios en la nube. Además, al eliminar la necesidad de suscripciones o costos mensuales asociados con plataformas de IA comerciales, esta alternativa se convierte en una opción accesible y eficiente para desarrolladores, investigadores y entusiastas de la inteligencia artificial.

Si buscas una herramienta potente que respete tu privacidad y te permita trabajar sin limitaciones, DeepSeek-R1 es una excelente elección. En las siguientes secciones, veremos cómo instalarlo y configurarlo correctamente en tu sistema para aprovechar al máximo su potencial.

¿Qué hace a DeepSeek-R1 tan especial?

DeepSeek-R1 no es solo otro modelo de inteligencia artificial, sino una opción innovadora que introduce mejoras significativas en comparación con otros sistemas tradicionales. Su enfoque de aprendizaje, su eficiencia en el uso de recursos y su flexibilidad como software de código abierto lo convierten en una opción atractiva tanto para desarrolladores como para investigadores. A continuación, exploramos las principales razones por las que DeepSeek-R1 destaca entre otras alternativas:

1. Aprendizaje por Refuerzo vs. Entrenamiento Supervisado

A diferencia de muchos modelos de IA convencionales que dependen en gran medida del entrenamiento supervisado con grandes volúmenes de datos etiquetados manualmente, DeepSeek-R1 adopta un enfoque diferente: el aprendizaje por refuerzo.

Este método permite que el modelo mejore su rendimiento mediante un proceso de prueba y error, desarrollando así habilidades de autoevaluación y refinando su razonamiento lógico a largo plazo. En otras palabras, en lugar de solo imitar patrones de datos previamente etiquetados, DeepSeek-R1 aprende a resolver problemas por sí mismo, lo que le otorga una mayor capacidad para manejar desafíos complejos y novedosos.

2. Eficiencia de costos y escalabilidad

Uno de los principales obstáculos para acceder a modelos de IA avanzados es el alto costo asociado a su uso, ya sea en forma de suscripciones mensuales o tarifas por procesamiento de tokens. DeepSeek-R1 resuelve este problema al permitir que los usuarios ejecuten versiones optimizadas del modelo en sus propios equipos, reduciendo o eliminando completamente estos costos.

- Para quienes tienen hardware de consumo estándar, existen versiones “distilled” del modelo que oscilan entre 1.5B y 70B parámetros, lo que las hace accesibles incluso para GPUs de gama media o, con ciertos ajustes, para CPUs potentes.

- Si cuentas con hardware más avanzado, puedes aprovechar la versión completa del modelo, que alcanza hasta 671B parámetros, ideal para tareas de alta complejidad, aunque requiere un sistema con capacidad computacional de gama alta.

Gracias a esta escalabilidad, DeepSeek-R1 ofrece una solución flexible que se adapta tanto a usuarios individuales como a empresas o centros de investigación con mayor poder de procesamiento.

3. Flexibilidad y libertad del código abierto

El hecho de que DeepSeek-R1 sea un modelo open-source significa que no existen restricciones en su uso, modificación o integración con otros sistemas. Esto abre un mundo de posibilidades para los desarrolladores y entusiastas de la IA:

- Puedes ajustar el modelo a tus necesidades específicas mediante fine-tuning, optimizándolo para tareas concretas.

- Es posible integrarlo con otras bibliotecas de inteligencia artificial para ampliar sus capacidades y mejorar su rendimiento.

- Incluso tienes la libertad de desarrollar tu propio servicio basado en DeepSeek-R1, creando herramientas personalizadas para análisis de datos, asistentes virtuales, generación de código y mucho más.

Requisitos previos para instalar y ejecutar DeepSeek-R1

Antes de comenzar con la instalación, es importante asegurarse de que tu equipo cumple con ciertos requisitos para garantizar un funcionamiento óptimo del modelo. Aquí te detallo lo que necesitas:

- 🖥️ Sistema operativo compatible: DeepSeek-R1 funciona en Linux y macOS. Si usas Windows, es necesario contar con WSL2 para ejecutar un entorno Linux dentro del sistema.}

- 💻 Manejo básico de la terminal: Será necesario utilizar la línea de comandos para instalar y ejecutar DeepSeek-R1, por lo que es recomendable conocer instrucciones básicas.

- 🛠️ Docker (opcional): Si planeas usar una interfaz web en lugar de trabajar directamente desde la terminal, necesitarás Docker para gestionar el entorno de ejecución.

- 🔽 Ollama (Opción 1): Es la herramienta que permite descargar y ejecutar DeepSeek-R1 de manera local. En este tutorial te explicaremos cómo configurarlo correctamente.

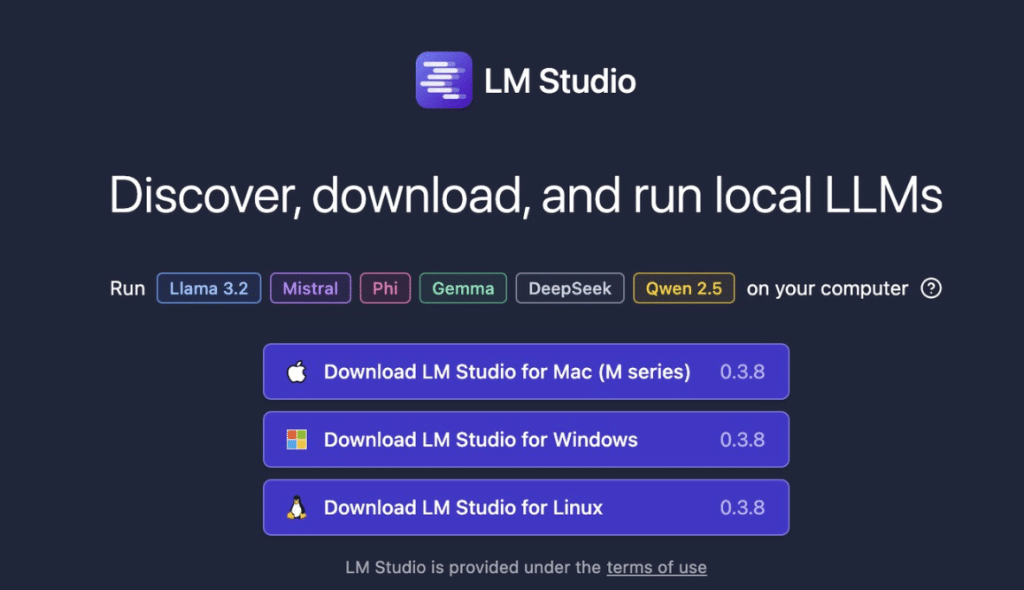

- 🔽 LMSTUDIO (Opción 2): Es la herramienta que permite descargar y ejecutar DeepSeek-R1 de manera local. En este tutorial te explicaremos cómo configurarlo correctamente.

También te podría interesar: Aprende qué es Docker y cómo funciona

DeepSeek-R1 en tu PC con LM Studio

Si prefieres una alternativa más sencilla y visual para ejecutar modelos de IA en tu computadora, puedes optar por LM Studio. Esta herramienta proporciona una interfaz gráfica que facilita la gestión y uso de modelos de lenguaje sin necesidad de depender exclusivamente de la línea de comandos.

🔹 ¿Qué es LM Studio?

LM Studio es un programa diseñado para ejecutar modelos de inteligencia artificial localmente en tu computadora de una manera más accesible y amigable. Su principal ventaja es que te permite cargar y utilizar modelos como DeepSeek-R1 sin necesidad de manejar comandos en la terminal.

📌 Ventajas de LM Studio:

✅ Interfaz gráfica intuitiva, ideal para quienes no quieren usar la terminal.

✅ Compatible con múltiples modelos de IA, incluyendo DeepSeek-R1.

✅ Disponible para Windows, macOS y Linux.

✅ Permite gestionar modelos de manera sencilla sin necesidad de configurar Ollama manualmente.

🔹 Cómo instalar LM Studio y usar DeepSeek-R1

1️⃣ Descarga LM Studio desde su página oficial:

🔗 https://lmstudio.ai

2️⃣ Instala la versión adecuada para tu sistema operativo (Windows, macOS o Linux).

3️⃣ Ejecuta LM Studio y accede a su catálogo de modelos.

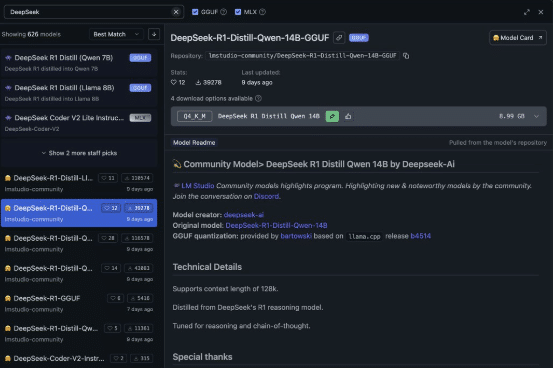

🔍 Cómo buscar y descargar DeepSeek-R1 en LM Studio

Una vez que tienes LM Studio instalado, puedes acceder a su buscador de modelos para encontrar y descargar DeepSeek-R1 en la versión que mejor se adapte a tu equipo.

Paso a paso para descargar DeepSeek-R1 en LM Studio:

1️⃣ Abre LM Studio en tu computadora.

2️⃣ Accede a la configuración y busca la opción de modelos.

3️⃣ Usa el buscador para escribir “DeepSeek” y encontrar las versiones disponibles.

4️⃣ Selecciona la versión adecuada según la capacidad de tu hardware:

- 1.5B parámetros → Modelo más liviano (~1.1GB), funcional en CPU y GPUs básicas.

- 7B parámetros → Requiere una GPU con al menos 8GB de VRAM.

- 70B parámetros → Modelo mucho más potente, pero solo viable en equipos con más de 24GB de VRAM.

5️⃣ Pulsa en “Download” para iniciar la descarga del modelo.

6️⃣ Una vez descargado, selecciona el modelo y ejecútalo dentro de LM Studio

Una vez que hayas descargado y seleccionado un modelo, aparecerá en la parte superior de LM Studio resaltado en morado. Esto indica que está listo para usarse.

📌 Ahora solo tienes que iniciar un nuevo chat y escribir cualquier pregunta o consulta. DeepSeek-R1 procesará tu solicitud y te mostrará la respuesta en la pantalla. Además, podrás ver el tiempo de procesamiento, lo que te ayudará a evaluar el rendimiento de tu modelo en tu equipo.

✅ Interfaz sencilla y accesible

✅ Respuestas en tiempo real sin depender de la nube

✅ Diferentes modelos según la capacidad de tu PC

Con LM Studio, puedes disfrutar de DeepSeek-R1 de manera local, sin complicaciones y con total privacidad

También podría interesarte: Tecsify: Campeones Globales en los World Summit Awards WSA 2024

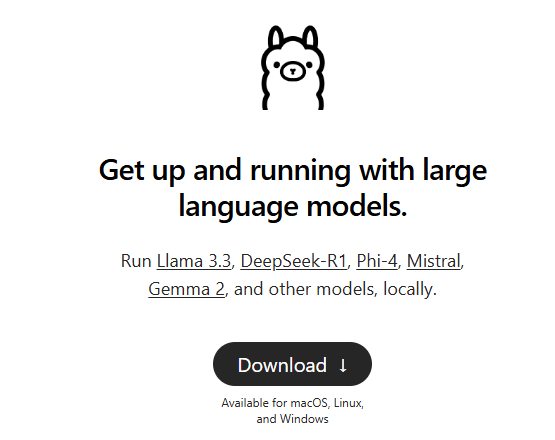

Instalando Ollama y descargando DeepSeek-R1

¿Qué es Ollama?

Ollama es una herramienta diseñada para gestionar y ejecutar modelos de lenguaje de manera local, funcionando de manera similar a Docker, pero específicamente para modelos de inteligencia artificial. Gracias a Ollama, podemos descargar y ejecutar DeepSeek-R1 sin necesidad de configuraciones complejas.

Instalación de Ollama

🔹 En Linux

Ejecuta el siguiente comando en la terminal para instalar Ollama:

curl -fsSL https://ollama.com/install.sh | sh

Luego, verifica que la instalación haya sido exitosa comprobando la versión:

ollama -v

🔹 En macOS

Si usas macOS, puedes instalar Ollama con Homebrew:

brew install ollama

Para iniciar el servicio automáticamente y evitar tener que ejecutarlo manualmente cada vez, usa:

brew services start ollama

Por último, verifica la instalación con:

ollama -v

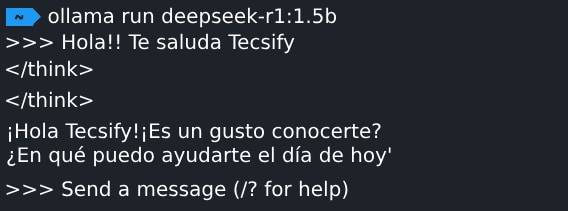

Descargar y ejecutar DeepSeek-R1 con Ollama

DeepSeek-R1 está disponible en distintas versiones, según la cantidad de parámetros y los recursos que tengas disponibles en tu equipo.

✅ 1.5B parámetros (Aproximadamente 1.1GB, apto para CPU y GPU con poca VRAM)

ollama run deepseek-r1:1.5b

✅ 7B parámetros (Aproximadamente 4.7GB, recomendado para GPUs con al menos 8GB de VRAM)

ollama run deepseek-r1

✅ 70B parámetros (Requiere más de 24GB de VRAM, solo para GPUs de gama alta)

ollama run deepseek-r1:70b

✅ 671B parámetros (Para hardware extremo con más de 300GB de VRAM)

ollama run deepseek-r1:671bEjecutando DeepSeek-R1

Cuando ejecutas alguno de los comandos anteriores, Ollama comenzará a descargar el modelo correspondiente y luego abrirá una terminal interactiva donde podrás hacer consultas directamente. Una vez completado el proceso, estarás listo para comenzar a usar DeepSeek-R1 de manera local.

💡 Tip para elegir el modelo adecuado:

Si tu equipo no tiene una GPU potente o mucha memoria RAM, te recomendamos empezar con la versión de 1.5B parámetros.

✔️ Ventajas: Solo ocupa alrededor de 1GB, es liviano y funcional.

❌ Limitaciones: Menor capacidad de razonamiento en comparación con los modelos más grandes.

Una vez que confirmes que todo funciona correctamente, puedes probar modelos más avanzados como la versión de 7B o 70B parámetros, según los recursos de tu equipo.

📌 Recuerda: En la página oficial de Ollama puedes encontrar otros modelos de IA compatibles que pueden ajustarse mejor a tus necesidades. 🔗 https://ollama.com

3.3. Montando la interfaz web con Docker

Si prefieres una interfaz visual amigable en lugar de interactuar con DeepSeek-R1 desde la terminal, puedes utilizar Open Web UI. Esta herramienta te permitirá gestionar y visualizar tus chats de forma más cómoda dentro de un entorno web.

🛠 Pasos para configurar la interfaz web

1️⃣ Instalar Docker

Antes de comenzar, necesitas tener Docker instalado en tu sistema.

- Descarga la versión de Docker correspondiente a tu sistema operativo desde docker.com.

- Sigue las instrucciones de instalación y verifica que funciona correctamente ejecutando:

docker --version2️⃣ Ejecutar el contenedor de Open Web UI

Una vez que Docker está instalado y en funcionamiento, puedes correr Open Web UI con el siguiente comando:

docker run -d -p --network=host \

-v open-webui:/app/backend/data \

-e OLLAMA_BASE_URL=http://127.0.0.1:11434 \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main 💡 Importante: Algunas opciones como --network=host pueden afectar la seguridad de la red, ya que comparten la conexión entre tu PC y el contenedor. Se recomienda solo para entornos de desarrollo.

3️⃣ Acceder a la interfaz web

Cuando el contenedor esté corriendo, podrás abrir la interfaz web en tu navegador visitando:

Aquí podrás crear una cuenta de administrador para gestionar la plataforma y personalizar la experiencia de uso.

4️⃣ Seleccionar y ejecutar el modelo

Dentro de la interfaz, selecciona DeepSeek-R1:1.5B o el modelo que prefieras según la capacidad de tu equipo.

¡Listo! Ahora puedes interactuar con DeepSeek-R1 en un entorno visual sin necesidad de enviar datos a servidores remotos. 🚀

4. Integrando la API de DeepSeek-R1 en tus proyectos

DeepSeek-R1 se puede utilizar en diferentes entornos, dependiendo de tus necesidades. Puedes integrarlo localmente, aprovechando la privacidad y el control total sobre el modelo, o utilizar su API en la nube, ideal para aplicaciones que requieren mayor escalabilidad.

6.1 Uso local (máxima privacidad con Ollama)

Si deseas ejecutar DeepSeek-R1 en tu propio equipo sin depender de servidores externos, puedes utilizar Ollama para exponer un endpoint compatible con OpenAI. Esto te permite integrar el modelo en tus proyectos sin necesidad de enviar datos a la nube.

Ejemplo en Python para conectarse a la instancia local:

import openai

# Conectarse a la instancia local de Ollama

client = openai.Client(

base_url="http://localhost:11434/v1", # Dirección del servidor local

api_key="ollama" # No se necesita clave real, es solo un identificador

)

# Realizar una consulta al modelo DeepSeek-R1

response = client.chat.completions.create(

model="deepseek-r1:1.5b", # Cambia a otra versión si lo deseas (7B, 70B, etc.)

messages=[{"role": "user", "content": "Escribe un resumen de la cultura Guatemalteca"}],

temperature=0.7

)

print(response)

🔹 Ventajas del uso local:

✅ Privacidad total: No se envían datos a servidores externos.

✅ Gratis y sin restricciones: Puedes ejecutar consultas sin costos adicionales.

✅ Bajo tiempo de respuesta: No dependes de la latencia de una API en la nube.

6.2 Uso en la nube (API oficial de DeepSeek-R1)

Si necesitas escalabilidad y acceso a hardware más potente, puedes optar por la API en la nube de DeepSeek-R1. Esta opción es ideal para aplicaciones de producción donde se requiere mayor capacidad de procesamiento sin la limitación del hardware local.

Ejemplo en Python utilizando la API oficial de DeepSeek:

import openai

# Conectarse a la API en la nube de DeepSeek

client = openai.OpenAI(

base_url="https://api.deepseek.com/v1",

api_key="TU_API_KEY" # Reemplaza con tu clave de API

)

# Solicitud al modelo DeepSeek-R1 en la nube

response = client.chat.completions.create(

model="deepseek-reasoner",

messages=[{"role": "user", "content": "Escribe un script de Python y FastAPI para hacer un crud en una DB de Postgresql"}],

max_tokens=1000

)

print(response)

🔹 Ventajas del uso en la nube:

✅ Acceso a modelos más grandes sin preocuparte por la capacidad de tu hardware.

✅ Escalabilidad: Ideal para aplicaciones con alto tráfico.

✅ Fácil integración: Similar a la API de OpenAI, por lo que es sencillo de implementar.

¿Cuál opción elegir?

A la hora de usar DeepSeek-R1, la mejor opción dependerá de tus necesidades y recursos. Aquí te dejo una comparación rápida para que elijas la más adecuada:

🔹 Si buscas privacidad total y cero costos

✔ Mejor opción: DeepSeek-R1 localmente con Ollama o LM Studio

✔ Razones:

✅ No dependes de servidores externos ni envías datos a la nube.

✅ No hay costos de suscripción ni pago por uso.

✅ Funciona sin conexión a internet, ideal para entornos privados.

✅ LM Studio ofrece una interfaz visual fácil de usar, mientras que Ollama brinda más control desde la terminal.

📌 Recomendado si tienes una PC con buena CPU/GPU y prefieres controlar tus datos.

🔹 Si necesitas potencia y escalabilidad

✔ Mejor opción: API oficial en la nube de DeepSeek

✔ Razones:

✅ Puedes acceder a modelos más potentes sin preocuparte por el hardware.

✅ Ideal para aplicaciones que necesitan procesar grandes volúmenes de datos.

✅ No tienes que descargar ni gestionar los modelos localmente.

📌 Recomendado si desarrollas una aplicación escalable o no quieres depender de la capacidad de tu equipo.

Hemos creado esta guía para que puedas instalar y ejecutar DeepSeek-R1 de manera sencilla en tu PC, ya sea con Ollama, LM Studio o a través de la API en la nube. Ahora queremos saber tu opinión

¡Déjanos tu comentario en la caja de comentarios! 📩 Tu feedback nos ayuda a mejorar y seguir creando contenido útil para la comunidad.

¡Danos tu opinión!